Oracle Compute Cloud@Customer

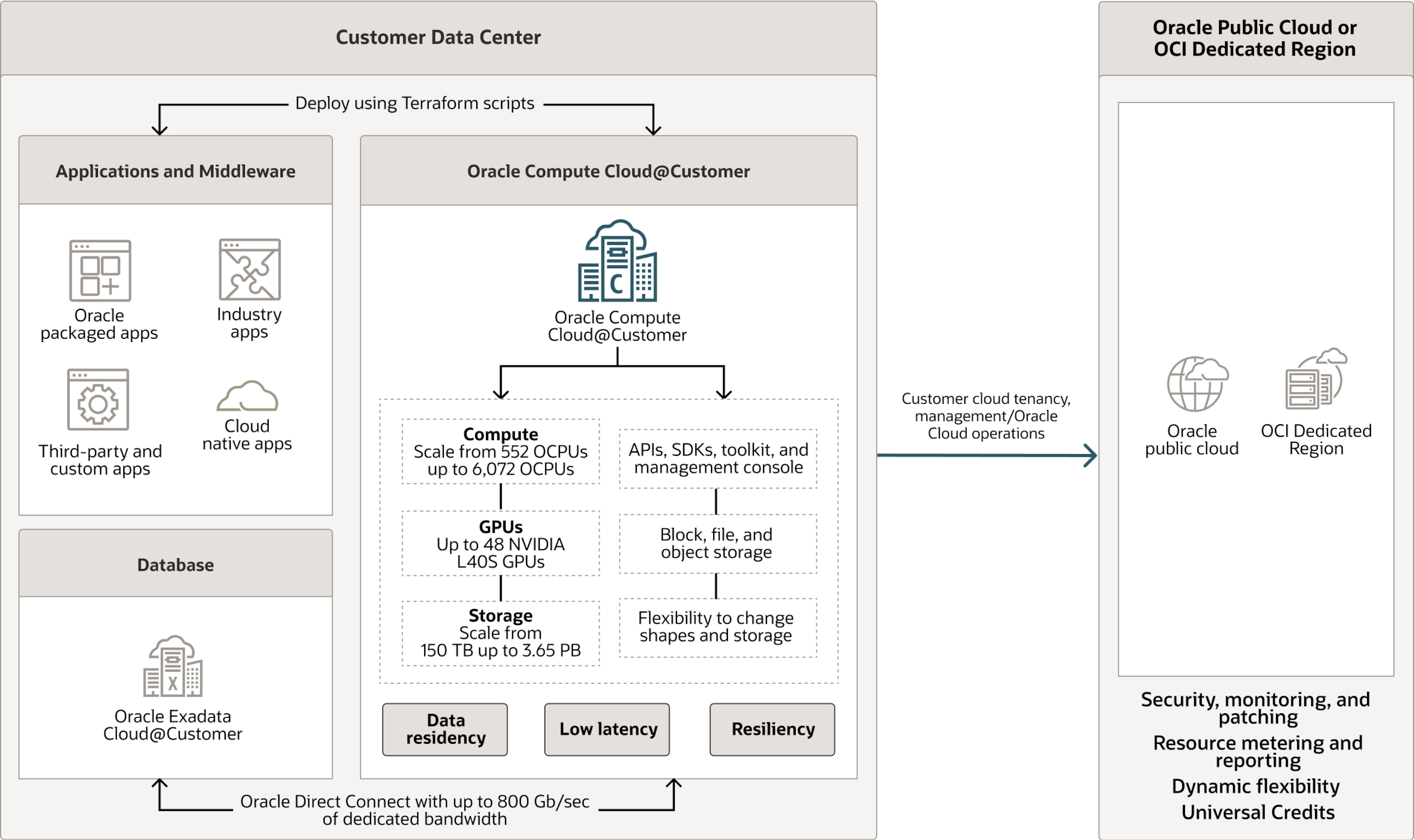

Oracle Compute Cloud@Customer는 완전 관리형 랙 스케일 인프라로 어디서나 Oracle Cloud Infrastructure(OCI) Compute를 사용할 수 있게 해 줍니다. Compute Cloud@Customer에서 스토리지 및 네트워킹 서비스를 통해 OCI 컴퓨트 및 GPU 구성을 실행함으로써 자체 데이터 센터에서 클라우드 자동화 및 경제성의 이점을 누려보세요. 자체 데이터 센터 내 클라우드 인프라에서 애플리케이션을 실행하고, GenAI의 파워를 활용할 수 있는 가장 간편한 방식입니다. 게다가 로컬 리소스 및 실시간 운영에 대한 데이터 레지던시, 보안성, 저지연 연결 문제도 해결할 수 있습니다.

온디맨드 웨비나: Oracle Cloud Infrastructure를 통해 AI를 에지에 구현하기

Oracle의 AI 기반 에지 솔루션이 에지 컴퓨팅의 온전한 잠재력을 활용하는 데 어떤 도움을 주는지 확인해 보세요.

OCI Compute를 어디서든 사용할 수 있는 완전 관리형, 랙 스케일 인프라

AI, 머신러닝, HPC, 비즈니스 애플리케이션을 위해 확장 가능한 클라우드 컴퓨트 파워와 GPU 가속 기능을 데이터 센터로 직접 가져올 수 있습니다.

분산형 클라우드를 사용하여 확장 가능한 OCI 컴퓨트, 스토리지, 네트워킹 서비스를 실행할 수 있습니다.

데이터 레지던시, 보안성, 저지연성 관련 요구 사항을 충족합니다.

동적 소비량 기반 가격 정책으로 비용이 절감됩니다.

고객의 전체 애플리케이션 스택을 현대화할 수 있습니다.

Oracle이 전담 관리 및 지원하는 인프라를 통해 유지보수 및 관리를 줄일 수 있습니다.

상시 암호화 기능 및 Oracle Operator Access Control을 사용하여 데이터를 보호합니다.

Compute Cloud@Customer를 선택하는 이유는?

Oracle Compute Cloud@Customer 고객은 자체 데이터센터의 고성능 클라우드 인프라상에서 OCI 서비스들을 통해 다양한 애플리케이션 및 미들웨어를 실행할 수 있습니다. 랙 스케일 플랫폼을 사용해 애플리케이션을 신속하게 배포할 수 있고, GPU 가속기 및 코드형 인프라 자동화도 옵션으로 선택할 수 있습니다. Compute Cloud@Customer와 Oracle AI Database용 Oracle Exadata Cloud@Customer를 결합하고, 클라우드 리소스를 사용하여 전체 애플리케이션 스택을 현대화할 수 있습니다.

-

단순성 및 경제성

100% OpEx 모델 및 동적 소비량 기준 가격 정책을 제공하는 완전 관리형 클라우드 인프라 및 OCI Compute 서비스가 비용 절감을 지원합니다.

-

유연성 및 고성능

각각 최대 96 컴퓨트 코어를 갖춘 유연한 VM 구성, AI 및 HPC 워크로드를 위한 옵션용 NVIDIA GPU, 확장 가능한 객체, 블록, 파일 스토리지를 사용해 클라우드 네이티브 애플리케이션을 포함한 다양한 애플리케이션들을 실행할 수 있습니다.

-

완전한 호환성

Oracle의 타 분산 클라우드에서와 동일한 OCI 서비스, API, 자동화 기능을 도입해 어디든 배포 가능한 워크로드를 손쉽게 개발할 수 있습니다.

-

어디든 배포 가능

기업 데이터 센터 및 원격 위치에 랙 스케일 인프라를 배포해 데이터 레지던시 및 저지연성 니즈를 해결할 수 있습니다.

Compute Cloud@Customer의 작동 방식

Compute Cloud@Customer는 Oracle 소유의 원격 관리형 클라우드 인프라로, 고객이 선택한 데이터 센터 또는 원격 위치에 설치됩니다. OCI Compute와 GPU 인스턴스를 관련 OCI 스토리지 및 네트워킹 서비스와 함께 실행할 수 있게 해 주죠. 데이터 센터 내에 클라우드 리소스를 저장하면 데이터 레지던시 요구 사항과 데이터 센터 에셋 및 실시간 운영을 위한 저지연성 니즈를 충족할 수 있습니다.

필요한 컴퓨트 코어, GPU, 인스턴스 및 총 스토리지 수를 선택하면 Oracle이 인프라를 제공, 설치, 유지, 관리까지 해 드립니다. 최소 48개월 이상 Compute Cloud@Customer를 구독하고, 사용한 만큼의 컴퓨트 및 스토리지 리소스에 대한 비용만 지불하세요. Compute Cloud@Customer는 고객이 기존에 사용 중인 OCI에서와 동일한 Oracle Universal Credits을 사용하는 100% OpEx 모델을 제공하며, 사용하지 않은 리소스에 대해 비용을 청구하지 않는 방식으로 비용 절감을 지원합니다.

Compute Cloud@Customer 또는 Exadata Cloud@Customer 사용 시 데이터는 상시 암호화 및 기타 OCI 보안 기능을 통해 보호됩니다. OCI Console과 공통 API는 Compute Cloud@Customer 및 Exadata Cloud@Customer에서 실행되는 서비스 및 애플리케이션을 관리합니다. 따라서 Oracle의 분산 클라우드 환경 전반에서의 워크로드 이전이 간편합니다.

Compute Cloud@Customer 사용 사례

-

데이터 센터에 구현된 클라우드를 통한 현대화

Oracle E-Business Suite을 비롯한 애플리케이션을 온프레미스 플랫폼에서 Compute Cloud@Customer로 이전한 뒤 Exadata Cloud@Customer에 직접 연결하면 성능을 개선하고, 관리 시간 및 비용을 줄일 수 있습니다. 또한 단일 Compute Cloud@Customer 플랫폼에 기존 워크로드 및 클라우드 네이티브 워크로드를 통합하면 비용을 절감할 수 있습니다.

-

중앙에서 관리하는 분산 클라우드

전국에 애플리케이션을 배포한 뒤, 단일 창에서 중앙 집중 방식으로 관리할 수 있습니다. 인프라 및 서비스 비용은 사용한 리소스에 대한 비용만이 청구되는, 전 세계적으로 일관된 가격 모델을 기반으로 합니다.

-

재해로부터 애플리케이션 리소스 보호

OCI를 통한 재해 복구 통합 관리를 바탕으로 대기 사이트의 Compute Cloud@Customer를 사용해 고객 데이터 센터 또는 OCI 리전에서 실행되는 애플리케이션 및 미들웨어 스택을 보호할 수 있습니다.

-

데이터베이스 계층과 애플리케이션 워크로드의 긴밀한 통합 활용

Compute Cloud@Customer with Exadata Cloud@Customer는 GenAI 워크로드 실행에 이상적인 플랫폼을 제공합니다(LLM, 데이터 분석, HPC 시뮬레이션을 활용한 인퍼런싱용 GPU 사용 등).

-

자체 데이터 센터에서 GPU 지원 클라우드 애플리케이션 실행하기

OCI GPU 인스턴스를 사용해 인퍼런싱용 LLM 등 GenAI 워크로드는 물론, 데이터 센터 내 HPC 데이터 분석 및 시뮬레이션 애플리케이션 모두를 실행할 수 있습니다.

Oracle Compute Cloud@Customer에 대한 분석가들의 평가

“대부분의 데이터는 여전히 온프레미스에 저장되어 있고, 그중 상당수가 Oracle Database에 저장되어 있습니다. 이 고객 중 다수가 AI의 이점을 누리고 싶어 하지만, AI 클라우드 서비스로의 데이터 이전을 꺼리는 고객들도 있습니다. NVIDIA GPU를 탑재한 Compute Cloud@Customer는 강력한 솔루션을 제공합니다. 고객이 온프레미스에서 GenAI 인퍼런스 또는 LLM/SLM 파인 튜닝을 실행할 수 있는 고성능 AI 플랫폼을 이용할 수 있게 해 주죠. 이 플랫폼에서는 그들의 데이터가 결코 데이터 센터를 떠나는 일이 없기 때문에 최고 수준의 보안 관리가 가능합니다. 또한 Exadata Cloud@Customer와 결합되는 경우, 이 플랫폼은 극적인 벡터 처리를 위해 Oracle Database와 함께 설계되었기 때문에 고객은 자사의 GenAI 모델을 Compute Cloud@Customer에서 실행하고, 내부 데이터에 대해 RAG 기술을 사용해 프롬프트에 대한 보다 연관성 높은 답변을 얻을 수 있습니다. 이 결함은 온프레미스 AI 워크플로에 강력한 가치를 제공합니다.”

“Oracle의 분산 클라우드 컴퓨팅 라인 확장으로 NVIDIA 랙을 위한 소규모, 저비용 옵션이 추가되었는데, 이는 생성형 AI 워크로드의 온프레미스 이전을 위한 장애물을 없애는 데 큰 성과였습니다. 지금까지는 Oracle의 Dedicated Region 및 Alloy 배포 옵션 외에는 언어 모델을 갖춘 워크로드 실행을 위해서는 퍼블릭 클라우드 하이퍼스케일러만이 유일한 대안이었기 때문입니다. 사내 정책에서부터 데이터 레지던시 요구사항에 이르기까지 다양한 이유로 기업 시스템의 많은 부분이 향후 상당 기간 동안 온프레미스에 남게 될 가능성이 높아졌습니다. Oracle Compute Cloud@Customer와 새로운 Private Cloud Appliance with NVIDIA GPU는 생성형 AI 워크로드를 데이터 센터로 가져다 줄 것입니다. NVIDIA L40S 프로세서는 OCI NVIDIA Superclusters에서 실행되는 인스턴스 대비 크기는 작지만, 앞으로 더욱 흔해질 것으로 예상되는, 보다 컴팩트한 모델에서 실행될 도메인별 엔터프라이즈 워크로드에는 더욱 적합한 것입니다.”

“Oracle은 혁신적인 Oracle Database 23ai 워크로드용 Exadata X11M 출시 직후 이번에는 애플리케이션 계층용 Compute Cloud@Customer with NVIDIA GPU를 출시했습니다. 이 솔루션은 기업 조직이 AI, HPC, 3D 그래픽 및 4K 스트리밍 전반의 까다로운 워크로드를 성공적으로 처리할 수 있도록 지원합니다. 기업들을 위한 또 다른 훌륭한 사용 사례는 사기 감지입니다. Oracle의 플랫폼과 NVIDIA의 GPU가 함께 실시간으로 이상 값을 찾아내고 사기를 감지합니다. 동시에 기업은 데이터 레지던시 요구 사항을 충족시킬 수 있죠.”

“Oracle의 분산 클라우드 전략의 일환으로, Compute Cloud@Customer with NVIDIA GPU는 OCI Compute를 온프레미스에 제공함으로써 AI 플랫폼 구축 시 추측의 영역을 없애줍니다. 재무 계약이 담긴, 클라우드 지원은 없는 단순한 상자로 위장한 경쟁사 제품들과 달리 Compute Cloud@Customer는 진짜 클라우드 경험을 위해 OCI에서와 동일한 API, 동일한 소프트웨어 및 제어창을 사용합니다. Oracle이 시의적절하게 내놓은 이 솔루션은 고객이 엄청난 선행 투자를 약정하지 않아도 소규모로 시작해 AI를 활용할 수 있게 지원합니다. 또한 Oracle Database 23ai용 Exadata Cloud@Customer 배포를 위한 완벽한 보완제이기도 합니다.”

“제품 생산 라인의 디지털 복제본을 배포하려는 제조 기업에게는 Oracle Compute Cloud@Customer with NVIDIA GPU가 완벽한 온프레미스 솔루션입니다. 기업은 현재 제조 운영에 아무런 영향을 미치지 않고도 비용을 줄이고, 시장 출시 기간을 단축하고, 품질 제어 능력 및 에너지 효율성, 지속가능성을 개선할 수 있습니다. 게다가 OCI 분산 클라우드의 이점을 온프레미스 환경으로 가져다 주는 사용량 기준 지불 모델을 바탕으로 Oracle Compute Cloud@Customer는 데이터를 특정 위치에서 저장 및 관리해야 하는 기업 조직의 니즈를 해결하고, 이들이 AI 기반 워크로드를 빠르게 활용할 수 있도록 준비시킬 수 있습니다.”

“Oracle의 Compute Cloud@Customer with NVIDIA GPU 확장으로 온프레미스에서 강력하고 확장 가능한 AI 역량을 필요로 하던 기업 조직들에게 매력적인 솔루션을 제공할 수 있게 되었습니다. 생성형 AI, LLM과 같은 까다로운 워크로드를 실행하고, 동시에 데이터 주권 관련 우려를 해소하는 역량 덕분에 이 솔루션은 재무 서비스, 헬스케어, 텔레콤 등의 산업에서 판을 뒤흔드는 게임 체인저의 역할을 하고 있습니다. 또한, Exadata Cloud@Customer와의 이상적인 결합을 통해 AI 애플리케이션 레이어를 관리하고, 동시에 Exadata가 Oracle Database 23ai AI Vector Search로 AI 데이터 레이어를 관리합니다.”

“Oracle은 온갖 종류로 변화할 수 있는 데이터베이스 플랫폼이자 AI 기능 전반에서 인상적인 성능을 제공한 Oracle Exadata X11M에 이어 Oracle Database 23ai AI Vector Search에서도 시작부터 'AI를 고객의 데이터에 직접 가져다주는' 제품이라는 메시지를 꾸준히 전달하고 있습니다. 방정식의 데이터 부분을 완성한 Oracle은 이제 AI 모델을 온프레미스에서 실행할 수 있게 해 주는 경제적인 가격의 컴퓨트 엔진, Compute Cloud@Customer with NVIDIA L40S GPU를 발표했습니다. 클라우드 사용량 모델을 갖춘 고성능 모듈식 모델이죠. 세 가지 장점을 모두 갖춘 이 솔루션은 생성형 AI 인퍼런싱, AI 모델 파인튜닝, RAG 등 가장 널리 사용되는 AI 사용 사례 대다수를 위한 엔드투엔드 워크플로를 지원하는 통합 아키텍처를 제공합니다. Oracle 환경을 실행 중이거나, 데이터 레지던시 요구 사항을 가지고 있거나, AI를 향한 첫 발을 내딛는 모든 CIO들은 포트폴리오에 Compute Cloud@Customer를 추가할 것을 진지하게 고려할 필요가 있습니다.”

“경쟁 우위를 점하기 위한 인공 지능 도입 경쟁에서 기업들은 혁신과 보안, 규제 준수 사이의 균형을 반드시 찾아야 합니다. 하지만 많은 기업들이 데이터 주권 및 레지던시 요구 사항에 관한 도전 과제에 직면하게 되고, 데이터를 처리할 장소 및 방식에 대해 우려를 제기합니다. Oracle의 Compute Cloud@Customer는 데이터를 고객의 데이터 센터에 안전하게 유지해 주는 온프레미스 클라우드 솔루션을 통해 이와 같은 문제를 해결합니다. 심지어 훨씬 더 커다란 주권 제어를 위해 인터넷 연결이 차단된 모드에서도 작동합니다. NVIDIA L40S GPU를 탑재한 이 플랫폼은 산업 전반에서 AI, 그래픽, 비디오 처리에 필요한 성능을 제공합니다. 보안성, 모듈성, 소비량 기반 가격 정책을 바탕으로 Compute Cloud@Customer는 엔터프라이즈 AI 도입을 위한 강력한 기반을 제공합니다.”

“AI Vector Search 및 검색 증강 생성(RAG)은 조직 전반의 데이터베이스에 상주하는 엔터프라이즈 데이터로부터 보다 효율적으로 가치를 추출하기 위해 기업이 도입하는 두 가지 기술입니다. 하지만 많은 IT 기업들은 최고의 성능과 효율성을 위해 AI Vector Search 및 RAG를 운영하고 지속적으로 튜닝하는 과정을 시간 소모가 많은, 정확도가 낮은 과학으로 여겨왔습니다. Oracle Database 23ai on Exadata X11M와 Compute Cloud@Customer with NVIDIA L40S GPU의 결합은 최적의 성능-효율성 균형을 유지하여 AI로부터의 가치 창출 과정을 전보다 어려움 없이, 정확하게 만들어 줍니다. 게다가 이 과정을 Oracle Compute Cloud@Customer를 통해 거치면 비용 효율성도 더욱 높아집니다.”

“기업들에게는 AI를 시작하는 것 자체가 주요 과제일 수 있습니다. Oracle Compute Cloud@Customer with NVIDIA L40S GPU는 고객이 직면할 수 있는 3가지 주요 문제들을 없애줍니다. 먼저 모듈식 아키텍처가 가진 진입 장벽을 없애줍니다. 소규모로 시작해서 필요에 따라 확장이 가능하죠. 그러면서도 여전히 중요한 AI 모델 실행에 필요한 성능을 제공합니다. 두 번째는 클라우드 구독 모델을 따른다는 점입니다. 따라서 사용한 만큼에 대해서만 비용이 부과됩니다. 세 번째는 보안 및 규제 준수 관련 위험이 크게 줄었다는 점입니다. Compute Cloud@Customer는 온프레미스에서 배포되고 실행되기 때문에 데이터가 고객의 데이터 센터를 벗어날 일은 결코 없습니다.”

“Oracle Compute Cloud@Customer는 데이터를 클라우드로 이전할 수 없는 기업들에게 확장 가능한 AI의 파워 및 사용량 기반의 클라우드 경제학이 제공하는 이점을 제공합니다. 확장 가능한 컴퓨트, 스토리지, 최대 48 NVIDIA L40S GPU를 갖춘 통합 아키텍처 덕분에 사용자는 인퍼런싱 및 기타 AI 사용 사례를 어디서나 손쉽게 실행할 수 있습니다.”

필요한 곳에서 활용하는 클라우드 AI 리소스: Oracle Compute Cloud@Customer 및 Oracle Private Cloud Appliance에서 구동되는 NVIDIA L40S GPU 발표

Director of Product Management, Sanjay Pillai

Principal Technical Product Manager, Jeevan Sreenivas

오늘날과 같이 빠르게 변화하는 세상에서는 실시간 의사 결정이 매우 중요하기 때문에 기업은 데이터가 어디에 있든 즉각적이고 실행 가능한 인텔리전스를 필요로 합니다. 미래의 AI는 중앙화된 클라우드 데이터 센터를 넘어 기업 조직 전반으로 확장될 것이며, 고성능, 초저지연성, 유연한 배포 옵션이 기업의 경쟁 우위를 결정할 것입니다. Oracle의 분산 클라우드 전략의 일환인 Oracle Compute Cloud@Customer with NVIDIA GPU 구성(오늘부터 주문 가능) 및 Oracle Private Cloud Appliance with GPU 구성(3월부터 주문 가능)의 출시를 기쁜 마음으로 발표합니다. NVIDIA L40S GPU를 통해 엔터프라이즈급 AI, 그래픽, 고성능 컴퓨팅 기능을 고객 데이터 센터를 포함하여 고객이 선택한 위치에 직접 가져다 드립니다.

게시물 전문 읽어보기추천 블로그

- 2024년 12월 18일 Oracle Compute Cloud@Customer용 Oracle WebLogic Server 발표

- 2024년 12월 5일 Oracle Compute Cloud@Customer 및 Private Cloud Appliance에서의 SR-IOV/VFIO 채권 생성 자동화

- 2024년 6월 18일 Compute Cloud@Customer용 Oracle NoSQL 단일 노드 데이터베이스

- 2024년 6월 11일 Oracle Compute Cloud@Customer용 MySQL Enterprise Edition

- 2024년 5월 13일 Compute Cloud@Customer용 Oracle Key Vault, 이제 Oracle AI Database의 보안을 강화하다

- 2024년 4월 3일 지원 개시: Oracle Compute Cloud@Customer에 배포 가능한 Oracle Container Engine for Kubernetes

- 2024년 1월 12일 2023년 우수 평가: Oracle Compute Cloud@Customer 및 Oracle Private Cloud Appliance

추가 Compute Cloud@Customer 리소스

-

관련 문서

- Oracle Compute Cloud@Customer 및 Oracle Private Cloud Appliance에 Fortinet의 FortiGate 차세대 HA 클러스터 배포하기(PDF)

- Oracle Compute Cloud@Customer에 Commvault 배포하기(PDF)

- Oracle AI Database배포하기: Compute Cloud@Customer 및 Private Cloud Appliance 상의 Real Application Clusters, Roving Edge 상의 스탠드얼론 배포(PDF)

- Compute Cloud@Customer를 사용하는 Roving Edge Devices를 위한 분산 멀티 노드 솔루션 배포(PDF)

- Oracle Compute Cloud@Customer에 NVIDIA AI Enterprise 배포하기(PDF)

- Oracle Compute Cloud@Customer 및 Private Cloud Appliance에서 NVIDIA NIM을 사용하여 LLaMA 3–8B Instruct Inference 실행(PDF)