Oracle Compute Cloud@Customer

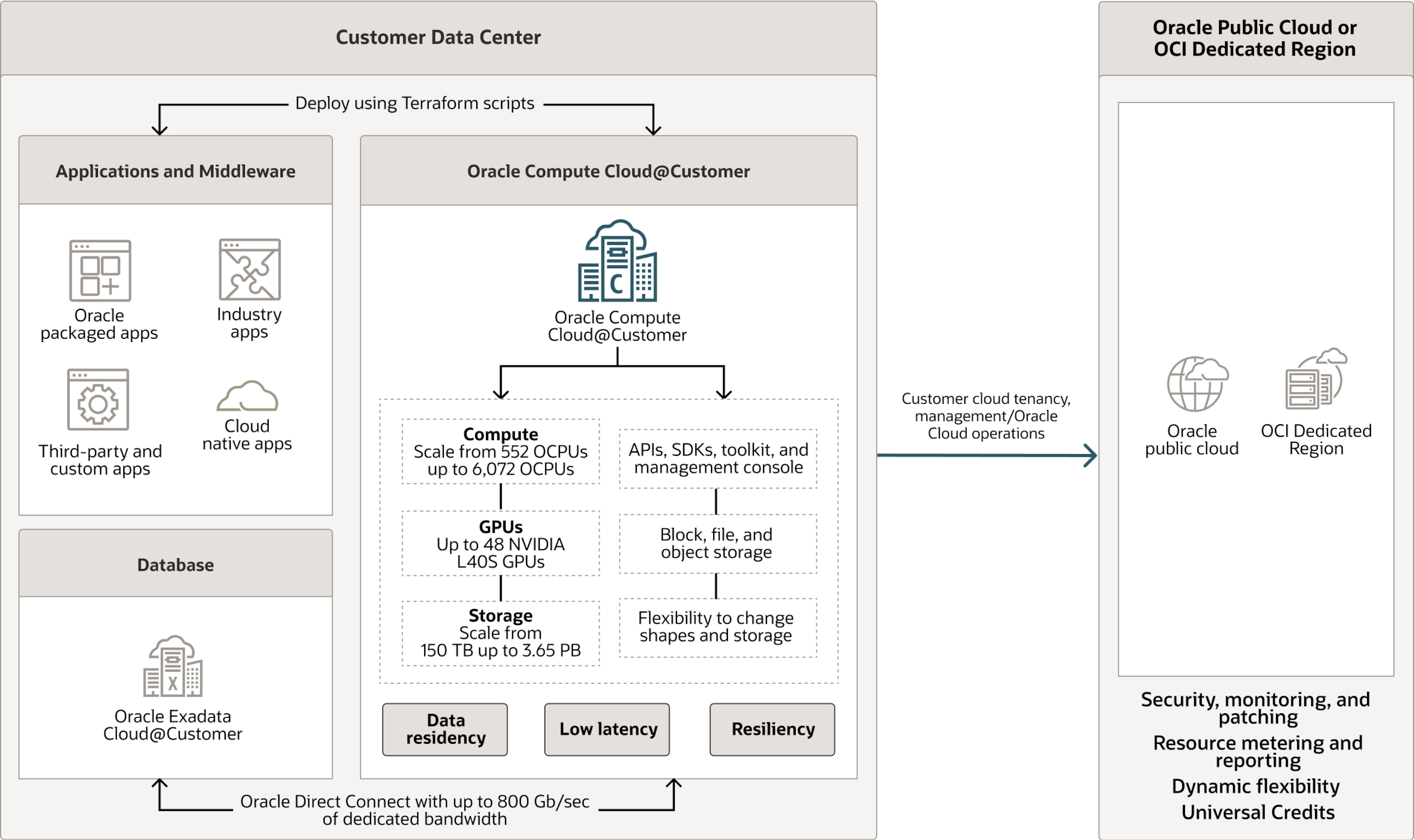

Oracle Compute Cloud@Customer は、完全に管理されたラックスケールのインフラストラクチャで、Oracle Cloud Infrastructure (OCI) Computeをどこからでも利用できるようにします。Compute Cloud@Customer上でストレージとネットワーキング・サービスを備えたOCIコンピュートとGPUシェイプを実行することで、データセンターでクラウドの自働化と経済性のメリットを得ることができます。これは、データセンター内のクラウドインフラストラクチャ上でアプリケーションを実行し、GenAIの力を活用する最も簡単な方法です。同時に、データレジデンシーやセキュリティ、ローカルリソースやリアルタイム処理との低レイテンシ接続といった要件にも対応できます。

オンデマンド・ウェビナー: Oracle Cloud InfrastructureによるエッジへのAIの導入

オラクルのAIによるエッジ・ソリューションが、エッジ・コンピューティングの可能性を最大限に活用できるよう支援する方法の詳細をご覧ください。

フルマネージドのラックスケール・インフラストラクチャにより、場所を選ばずOCI Computeの実行が可能

AIや機械学習、HPC、業務アプリケーションのために、スケーラブルなクラウドのコンピュート・パワーとGPUアクセラレーションを自社のデータセンターに導入します。

分散クラウドでスケーラブルなOCIコンピュート・ストレージ・ネットワーキング・サービスを実行します。

データ・レジデンシー、セキュリティ、レイテンシに関する要件に対応します。

動的な重量課金によりコストを削減します。

アプリケーション・スタック全体を最新化します。

オラクルがフルマネージドでサポートするインフラストラクチャにより、メンテナンスと管理業務を削減します。

常時暗号化とOracle Operator Access Controlでデータのセキュリティを確保します。

Compute Cloud@Customerが選ばれる理由

Compute Cloud@Customerを使えば、OCIサービスを利用して、アプリケーションやミドルウェアを自社のデータセンター内にある高性能なクラウド・インフラストラクチャ上で実行できます。さらに、オプションのGPUアクセラレーションとインフラストラクチャ・アズ・コードの自動化機能を備えたラックスケール・プラットフォームを使用して、アプリケーションを迅速に導入できます。Compute Cloud@CustomerとOracle Exadata Cloud@Customer for Oracle AI Databaseを組み合わせることで、クラウド・リソースを活用し、アプリケーション・スタック全体を最新化します。

-

シンプルで低コスト

フルマネージドのクラウド・インフラストラクチャとOCIコンピュート・サービスを、100%運用費モデルと動的な重量課金で利用し、コストを削減します。

-

柔軟かつ強力

クラウドネイティブアプリケーションを含むアプリケーションを、最大96コアの柔軟なVMシェイプ、AIおよびHPCワークロード向けのオプションのNVIDIA GPU、そしてスケーラブルなオブジェクト・ブロック・ファイルストレージを使って実行できます。

-

完全な互換性

オラクルの他の分散クラウドと同じOCIサービス、API、および自動化を活用して、どこにでも展開できるワークロードを簡単に開発できます。

-

どこにでも導入可能

自社のデータセンターやリモート拠点にラックスケールのインフラストラクチャを導入することで、データ・レジデンシーや低レイテンシのニーズに対応できます。

Compute Cloud@Customerの仕組み

Compute Cloud@Customer は、Oracle が所有しリモートで管理するクラウド・インフラストラクチャであり、お客様が指定するデータセンターやリモート拠点に設置されます。このインフラストラクチャにより、OCIのComputeインスタンスやGPUインスタンス、および関連するOCIストレージやネットワークサービスを実行できます。クラウドリソースを自社のデータセンター内に設置することで、データ・レジデンシー要件に対応しながら、データセンター資産やリアルタイム処理との低レイテンシ接続も可能になります。

お客様が必要なコンピュートコア数、GPUインスタンス数、ストレージ容量を選択すると、オラクルがそのインフラを提供・設置・保守・管理します。Compute Cloud@Customerインフラストラクチャを最低48か月間ご契約いただき、ご利用分のコンピュートとストレージのコストのみをお支払いください。このサービスは、100% 運用費(OpEx)モデルを採用しており、OCIと共通のOracle Universal Creditsを使用できるほか、未使用のリソースには課金されないため、コストの最適化にも貢献します。

Compute Cloud@CustomerやExadata Cloud@Customerを利用する際は、データは常時オンの暗号化などのOCIセキュリティ機能により保護されます。OCIコンソールおよび共通のAPIにより、Compute Cloud@CustomerおよびExadata Cloud@Customer上のOCIリージョンで実行されるサービスとアプリケーションを管理し、オラクルの分散クラウド環境全体にまたがるワークロードの移行を容易にします。

Compute Cloud@Customerのユースケース

-

データセンターにクラウドを導入して最新化を実現

Oracle E-Business Suiteをはじめとするアプリケーションを、従来のオンプレミス環境からCompute Cloud@Customerへ移行し、Exadata Cloud@Customerと直接接続することで、パフォーマンスの向上、管理工数の削減、コストの最適化を図ることができます。従来型のワークロードとクラウドネイティブなワークロードを単一のCompute Cloud@Customer上に統合することで、さらにコスト効率を高めることが可能です。

-

分散クラウドを一元管理

国内各地にアプリケーションを分散配置しながら、単一の管理画面から一元的に運用することができます。インフラやサービスにかかる費用はOpEx(運用コスト)として扱え、使用した分だけ支払うグローバルに一貫した従量課金モデルにより、柔軟で透明性の高いコスト管理が可能です。

-

災害からアプリケーション資産を保護

本番環境がお客様のデータセンターやOCIリージョンにある場合でも、Compute Cloud@Customerをスタンバイサイトとして構成することで、OCIによるディザスタリカバリのオーケストレーションを通じてアプリケーションやミドルウェアスタックを保護できます。

-

アプリケーションとデータベース層の緊密な統合を活用

Compute Cloud@CustomerとExadata Cloud@Customerを組み合わせることで、LLM推論処理におけるGPU活用やデータ分析、高性能計算(HPC)シミュレーションといった生成AIワークロードに最適なプラットフォームを提供します。

-

GPU対応クラウドアプリケーションをお客様のデータセンター内で実行

OCIのGPUインスタンスを活用することで、自社データセンター内でLLMによる推論処理、HPCベースのデータ分析やシミュレーションといった生成AIワークロードを実行できます。

Oracle Compute Cloud@Customerに関するアナリストのコメント

「ほとんどのデータはいまだにオンプレミスにあり、その多くがOracle Database上に存在しています。AIの恩恵を受けたいと考えているお客様は多いものの、AIクラウドサービスにデータを移すことに抵抗を感じるケースもあります。Compute Cloud@CustomerはNVIDIA GPUを搭載しており、そうしたニーズに対して非常に魅力的なソリューションを提供します。このプラットフォームにより、お客様はオンプレミスにあるデータを外部に移すことなく、自社データセンター内で生成AIの推論やLLM/SLMのファインチューニングを行うための高性能なAI基盤を活用できます。これにより最大限のセキュリティ管理を実現できます。さらに、高度なベクトル処理のためにOracle Databaseと共同開発されたプラットフォームであるExadata Cloud@Customerと組み合わせることで、お客様はCompute Cloud@Customer上で生成AIモデルを実行し、自社データにRAG技術を適用することで、プロンプトに対してより適切な回答を導き出すことが可能になります。この組み合わせにより、オンプレミス環境におけるAIワークフローに対して、非常に高い価値を提供します。」

「オラクルは分散クラウド・コンピューティング製品を拡張し、NVIDIAラック向けのより小型・低コストな選択肢を追加したことで、生成AIワークロードをオンプレミスに導入するための大きな一歩を踏み出しました。これまで、オラクルのDedicated RegionやAlloyによる導入以外では、言語モデルを利用したワークロードを実行するには、事実上パブリック・クラウドのハイパースケーラーを使うしかありませんでした。しかし、社内ポリシーやデータ・レジデンシーに関する要件など、さまざまな理由から、企業の多くは今後もオンプレミスを使い続けると予想されます。Oracle Compute Cloud@Customerと、NVIDIA GPUを搭載した新しいPrivate Cloud Applianceにより、生成AIワークロードをデータセンター内で実行できるようになります。NVIDIA L40Sプロセッサは、OCIのNVIDIAスーパークラスタで使用されるインスタンスと比べて小型ではありますが、よりコンパクトなモデルで動作する、業種特化型のエンタープライズ・ワークロードに適したサイズ感であり、将来的にはこうした形態が一般化していくと考えられます。」

「Oracle Database 23aiワークロード向けの革新的なExadata X11Mプラットフォームのリリースに続き、オラクルはアプリケーション層向けにNVIDIA GPUを搭載したCompute Cloud@Customerを発表しました。これにより、組織はAI、HPC、3Dグラフィックス、4Kストリーミングといった要求の厳しいワークロードに対応し、ビジネスを成功に導くことができます。もう一つの重要なユースケースとして挙げられるのが不正検知です。オラクルのプラットフォームとNVIDIAのGPUを組み合わせることで、リアルタイムで異常を検出し、不正を特定することが可能になります。さらに、これらの仕組みはデータ・レジデンシーへの対応にも貢献します。」

「オラクルの分散クラウド戦略の一環として、NVIDIA GPUを搭載したCompute Cloud@Customerは、OCI Computeをオンプレミスで提供し、AIプラットフォームの構築における不確実性を取り除きます。クラウド機能を欠いた、他社によるファイナンス契約付きハードウェア製品とは異なり、Compute Cloud@CustomerはOCIと同じAPI、同じソフトウェア、同じコントロールプレーンを使用しており、真のクラウド体験を提供します。このオラクルのソリューションは、巨額の初期投資をせずに、小さく始めてAIを導入できるタイムリーな選択肢です。さらに、Oracle Database 23ai向けのExadata Cloud@Customer環境にも最適な補完となります。」

「製造ラインのデジタルレプリカを導入しようとする製造業の企業にとって、NVIDIA GPUを搭載したOracle Compute Cloud@Customerは、オンプレミス環境における理想的なソリューションです。企業はこれを活用することで、コストと市場投入までの時間を削減し、品質管理を向上させ、エネルギー効率と持続可能性を高めることができます。しかも、現在の製造業務に影響を与えることなく実現可能です。また、OCIの分散クラウドのメリットをオンプレミス環境に取り入れる従量課金モデルにより、特定の場所にデータを保存・管理する必要がある企業のニーズにも対応し、AI駆動型ワークロードの迅速な立ち上げを支援します。」

「NVIDIA GPU拡張機能を備えたOracleのCompute Cloud@Customerは、オンプレミスで強力かつスケーラブルなAI機能を必要とする組織にとって非常に魅力的なソリューションです。生成AIやLLMといった負荷の高いワークロードを実行しつつ、データ主権に関する要件にも対応できる点が、金融、医療、通信といった業界にとって大きなゲームチェンジャーとなります。さらに、Exadata Cloud@Customerとの組み合わせにより、Compute Cloud@CustomerがAIのアプリケーション層を担い、ExadataはOracle Database 23aiのAIベクトル検索機能を使ってAIのデータ層を管理するという理想的な構成が実現します。

オラクルは、「データにAIを導入」という方針を引き続き推進しており、その第一歩としてOracle Database 23aiのAIベクトル検索を提供し、続いてOracle Exadata X11Mをはじめとする全バリエーションのデータベースプラットフォームを展開することで、AI機能全体にわたって印象的なパフォーマンスを実現しています。データ側の基盤を完成させたオラクルは今、オンプレミス環境でAIモデルを実行するための経済的なコンピュートエンジンとして、NVIDIA L40S GPUを搭載したCompute Cloud@Customerを発表しました。これは、クラウド消費モデルを採用した高性能かつモジュール型のソリューションです。この3つの要素を組み合わせることで、生成AIの推論、AIモデルのファインチューニング、RAGなど、幅広い主要なAIユースケースに対応するエンドツーエンドのワークフローを支える統合アーキテクチャが実現します。オラクル製品を既に活用しているCIOはもちろん、データ・レジデンシー要件に対応しなければならない企業や、これからAI導入に取り組もうとしている組織は、Compute Cloud@Customerを有力な選択肢として考慮するべきでしょう。」

「競争優位を確立するためにAIの導入を急ぐ企業にとって、イノベーションとセキュリティおよびコンプライアンスとのバランスを取ることは不可欠です。しかし多くの企業が、データ主権やデータ・レジデンシーに関する要件に直面しており、自社のデータがどこで、どのように処理されるかに不安を抱えています。オラクルのCompute Cloud@Customerは、これらの課題に対処するオンプレミス型のクラウドソリューションであり、お客様のデータセンター内でデータを安全に保持できる環境を提供します。さらに、ネットワークから切り離された状態でも動作可能で、より高度な主権管理を実現します。NVIDIA L40S GPUを搭載しており、AI処理はもちろん、グラフィックスや映像処理など、さまざまな業種で求められる高性能な処理にも対応可能です。セキュリティ、モジュール型の構成、そして従量課金モデルを兼ね備えたこのプラットフォームは、企業がAIを導入するための強力な基盤を提供します。」

「AIベクトル検索と検索拡張生成(RAG)は、企業が組織内のデータベースに分散して存在するエンタープライズデータから、より効率的に価値を引き出すために活用しているテクノロジーです。しかし、AIベクトル検索やRAGを本番環境で実用化し、さらに継続的にチューニングして最適なパフォーマンスと効率を実現することは、多くのIT部門にとって時間のかかる複雑な作業であり、必ずしも正確に行えるとは限りません。その点で、Oracle Database 23ai on Exadata X11Mと、NVIDIA L40S GPUを搭載したCompute Cloud@Customerの組み合わせは、性能と効率性の最適なバランスを実現し、よりスムーズかつ正確にAIから価値を引き出ことができます。さらに、この環境をCompute Cloud@Customerとして従量課金制で利用できることにより、コスト面でも優れた柔軟性と経済性を提供します。」

「AIの導入は、多くの組織にとって大きなハードルとなることがあります。NVIDIA L40S GPUを搭載したOracle Compute Cloud@Customerは、この課題に関する3つの主要な障壁を取り除きます。まず第1に、モジュール型アーキテクチャにより、小規模な構成から始めて必要に応じて拡張できるため、導入の敷居が下がります。しかも、大規模なAIモデルを実行するために十分な性能も確保されています。第2に、クラウド型のサブスクリプションモデルを採用しているため、使用した分だけ課金される柔軟な価格体系が利用できます。第3に、Compute Cloud@Customerはオンプレミスに導入されるため、データがお客様のデータセンター外に出ることはなく、セキュリティやコンプライアンスに関するリスクを大幅に軽減できます。」

「Oracle Compute Cloud@Customerは、クラウドにデータを移動できない組織に対しても、スケーラブルなAIの処理能力と従量課金制によるクラウド経済性をもたらします。スケーラブルなコンピュート、ストレージ、そして最大48基のNVIDIA L40S GPUを備えた統合アーキテクチャにより、LLMによる推論処理やその他のAIユースケースをあらゆる場所で簡単に実行できるようにします。」

必要な場所でクラウドAIリソースを利用:NVIDIA L40S GPUを、Oracle Compute Cloud@CustomerとOracle Private Cloud Applianceで提供開始

プロダクト・マネジメント担当ディレクター、Sanjay Pillai

プリンシパル・テクニカル・プロダクト・マネージャー、Jeevan Sreenivas

リアルタイムの意思決定が重要な現在のペースの速い世界では、企業はデータが保存されている場所を問わず、即座に実用的なインテリジェンスを求めています。AIの未来は、一元化されたクラウド・データセンターを越えて、高いパフォーマンス、超低レイテンシ、柔軟な導入オプションが競争上の優位性を推進する組織全体のさまざまな場所へと拡大します。オラクルの分散クラウド戦略の一環として、NVIDIA L40S GPUを搭載した「Oracle Compute Cloud@Customer」(本日より受注開始)および、同じくGPU構成を備えた「Oracle Private Cloud Appliance」(3月より受注開始)の提供を発表いたします。これらのソリューションにより、エンタープライズクラスのAI、グラフィックス、高性能コンピューティング(HPC)機能を、自社データセンターを含む任意のロケーションに直接導入することが可能になります。

全文を読む注目のブログ

- 2024年12月18日 Oracle Compute Cloud@Customer 向け Oracle WebLogic Server の発表

- 2024年12月5日 Oracle Compute Cloud@Customer およびプライベート・クラウド・アプライアンスでの SR-IOV/VFIO ボンディングの作成の自動化

- 2024年6月18日 Oracle NoSQL Single Node Database for Compute Cloud@Customer

- 2024年6月11日 MySQL Enterprise Edition for Oracle Compute Cloud@Customer

- 2024年5月13日 Oracle Key Vault for Compute Cloud@CustomerがOracle AI Databaseへのアクセスをより安全に

- 2024年4月3日 Oracle Container Engine for KubernetesがOracle Compute Cloud@Customerで利用可能に

- 2024年1月12日 Stellar 2023 Year in Review:Oracle Compute Cloud@CustomerおよびOracle Private Cloud Appliance

Compute Cloud@Customerのその他のリソース

-

関連ドキュメント

- Oracle Compute Cloud@CustomerおよびOracle Private Cloud ApplianceへのFortinetのFortiGate 次世代HAクラスタの導入(PDF)

- Oracle Compute Cloud@Customer での Commvault の導入 (PDF)

- Real Application Clusters(RAC) on Compute Cloud@Customer および Private Cloud Appliance、ならびにRoving Edge 上でのスタンドアロン導入(PDF)

- Compute Cloud@Customerを使用したRoving Edgeデバイス向けの分散マルチノードソリューションの導入 (PDF)

- Oracle Compute Cloud@Customer への NVIDIA AI Enterprise の導入(PDF)

- Oracle Compute Cloud@CustomerおよびPrivate Cloud Appliance上におけるNVIDIA NIMを使用するLLaMA 3–8B Instruct Inferenceの実行(PDF)

-

関連するクラウド製品