Instances GPU

Oracle Cloud Infrastructure (OCI) Compute fournit l'évolutivité et les performances de pointe pour les instances sans système d'exploitation et de machine virtuelle (VM) optimisées par des GPU NVIDIA et AMD pour les graphiques grand public, l'inférence d'IA, l'entraînement d'IA, les jumeaux numériques et le HPC.

Lisez les dernières annonces d'OCI

-

NVIDIA Blackwell

Découvrez la disponibilité des systèmes NVIDIA GB200 NVL72 sur NVIDIA DGX Cloud et OCI.

-

Collaboration entre Oracle et AMD

Oracle et AMD ont annoncé que les GPU AMD Instinct MI355X seront disponibles sur OCI pour les charges de travail d'entraînement et d'inférence d'IA à grande échelle.

-

Seekr choisit l'IA fiable d'OCI

Choisissez l'infrastructure d'IA OCI pour accélérer rapidement les déploiements d'IA d'entreprise, l'entraînement d'IA multinœuds et les agents.

-

Premiers principes : superclusters Zettascale

Découvrez comment les réseaux de cluster d'OCI alimentent l'IA générative évolutive.

-

Souveraineté de l'IA

Oracle et NVIDIA proposent une IA souveraine en tout lieu.

-

GA pour le plug-in d'appareil de processeur graphique NVIDIA

Le plug-in dans OCI Kubernetes Engine offre davantage de contrôle et de flexibilité.

-

Modèles de base d'IA OCI

Déployez et adaptez facilement les charges de travail d'IA en production.

-

Processeurs graphiques AMD Instinct MI300X

Les instances sans système d'exploitation d'OCI Compute avec des processeurs graphiques AMD sont proposées en disponibilité générale.

Découvrez comment l'infrastructure Oracle AI et les processeurs graphiques AMD Instinct fournissent une base d'IA/ML hautes performances, évolutive et rentable.

Pourquoi utiliser OCI pour les instances de GPU ?

Évolutivité

131 072

Nombre maximal de GPU par supercluster OCI1

Performances

3 200

Jusqu'à 3 200 Gb/s de bande passante réseau de cluster RDMA2

Valeur

220 %

Les GPU des autres fournisseurs de services en nuage peuvent coûter jusqu'à 220 % plus cher3

Choix

VM/BM

Redimensionnement avec machine virtuelle et performances avec des instances sans système d'exploitation

1. OCI Supercluster évolue jusqu'à 131 072 processeurs graphiques NVIDIA Blackwell B200 ; 131 072 processeurs graphiques NVIDIA Blackwell B200 dans les superpuces NVIDIA Grace Blackwell GB200 ; 65 536 processeurs graphiques NVIDIA H200 Tensor Core ; 32 768 processeurs graphiques NVIDIA A100 Tensor Core ; 16 384 processeurs graphiques NVIDIA H100 Tensor Core ; et 16 384 processeurs graphiques AMD MI300X.

2. Pour les instances sans système d'exploitation avec des processeurs graphiques NVIDIA B200, H200 et H100 et des accélérateurs AMD Instinct MI300X.

3. Tarification à la demande du 5 juin 2024.

Inscrivez-vous au nouveau programme d'essai avant d'acheter pour OCI Compute avec des GPU MI300X AMD Instinct.

Caractéristiques clés des instances GPU

OCI est le seul fournisseur infonuagique majeur à proposer des instances sans système d'exploitation avec des GPU NVIDIA et AMD pour des performances élevées, sans frais de virtualisation. Pour les points de reprise lors de l'entraînement de l'IA, nos instances fournissent le stockage le plus local par nœud (61,4 To avec des GPU H100).

GPU NVIDIA et AMD à hautes performances

GPU NVIDIA Tensor Core

OCI offre la valeur et les performances les plus élevées pour les instances de calcul sans système d'exploitation et de machine virtuelle optimisées par les processeurs graphiques NVIDIA Blackwell, les processeurs graphiques H200 Tensor Core, les processeurs graphiques H100 Tensor Core, les processeurs graphiques L40S, les processeurs graphiques A100 Tensor Core, les processeurs graphiques A10 Tensor Core et les processeurs graphiques NVIDIA de générations précédentes.

Superpuces NVIDIA

OCI propose la Superpuce NVIDIA GB200 Grace Blackwell dans des superclusters qui évoluent jusqu'à plus de 100 000 processeurs graphiques.

Accélérateurs AMD Instinct

OCI propose des processeurs graphiques AMD Instinct MI300X avec 192 Go de mémoire à un prix compétitif de 6 $ par processeur graphique et par heure.

Mise en réseau de cluster à hautes performances

La mise en réseau de clusters à faible latence d'Oracle, reposant sur l'accès direct à distance à la mémoire (RDMA), fournit une latence de l'ordre de la microseconde.

Déployez vos applications sur des machines virtuelles, des instances sans système d'exploitation et des clusters Kubernetes

Instances de VM

Pour les machines virtuelles, choisissez parmi les architectures GPU Hopper, Ampere et d'anciennes générations de NVIDIA avec 1 à 4 cœurs, 16 à 64 Go de mémoire GPU par machine virtuelle et jusqu'à 48 Gb/s de bande passante réseau.

Instances sans système d'exploitation

Utilisez OCI Supercluster avec des instances sans système d'exploitation qui incluent des GPU AMD Instinct, des GPU NVIDIA Blackwell ou des Superchips, des GPU NVIDIA Hopper ou des Superchips et des GPU NVIDIA Ampere.

Orchestration Kubernetes

Tirez parti de Kubernetes géré, du maillage de services et du registre de conteneurs pour orchestrer l'entraînement et l'inférence de l'IA et de l'apprentissage automatique (ML) avec les conteneurs.

Accédez à des logiciels rapidement accessibles

Accédez à des logiciels et aux images disque

Oracle Cloud Marketplace fournit des logiciels et des images disque pour la science des données, les analyses, l’intelligence artificielle (IA) et des modèles d'apprentissage automatique afin que les clients puissent analyser rapidement leurs données.

NVIDIA AI Enterprise

Accédez à NVIDIA AI Enterprise, une plateforme logicielle complète pour l'IA de science des données et de production, y compris l'IA générative, la vision par ordinateur et l'IA vocale.

NVIDIA DGX Cloud

NVIDIA DGX Cloud sur OCI est une plateforme de formation en tant que service de l'IA, offrant aux développeurs une expérience sans serveur optimisée pour l'IA générative.

NVIDIA GPU Cloud Machine Image

Utilisez NVIDIA GPU Cloud Machine Image pour des centaines d'applications optimisées pour le GPU pour l'apprentissage automatique, l'apprentissage profond et le calcul haute performance, couvrant un large éventail de secteurs d'activité et de charges de travail.

NVIDIA RTX Virtual Workstation

Proposez des postes de travail performants à vos collaborateurs là où ils en ont besoin en exécutant NVIDIA RTX Virtual Workstation sur Oracle Cloud.

Contrôlez votre environnement informatique et vos données d'IA

Nuage distribué

Associé au calcul GPU, le nuage distribué d'OCI aide les entreprises à exécuter des services d'IA et de nuage là où et comment ils sont nécessaires.

Nuage souverain

Prenez en charge la résidence des données dans une région ou un pays, notamment l'UE, les États-Unis, le Royaume-Uni et l'Australie.

OCI Dedicated Region

Déployez une région infonuagique complète dans votre centre de données avec OCI Dedicated Region pour conserver un contrôle total de vos données et applications.

Oracle Alloy

Devenez partenaire d'Oracle Alloy et fournissez vos services en nuage pour répondre à des besoins spécifiques du marché.

Microservices et conteneurs

Container registry

Les développeurs qui créent des applications à l’aide de conteneurs exploitent un service de registre de conteneur privé hautement disponible géré par Oracle pour stocker et partager des images de conteneurs. Poussez ou tirez des images Docker vers et depuis le registre à l’aide de l’API Docker V2 et de l’interface de lignes de commande (CLI) Docker standard. Les images peuvent être extraites directement dans un déploiement de Kubernetes.

Oracle Functions

Les fonctions en tant que service (FaaS) permettent que les développeurs exécutent des applications serverless qui s’intègrent à Oracle Cloud Infrastructure, à Oracle Cloud Applications et à des services tiers. Augmentez l’efficacité des développeurs avec la communauté du code source libre Fn Project.

Cas d'utilisation d'instances GPU

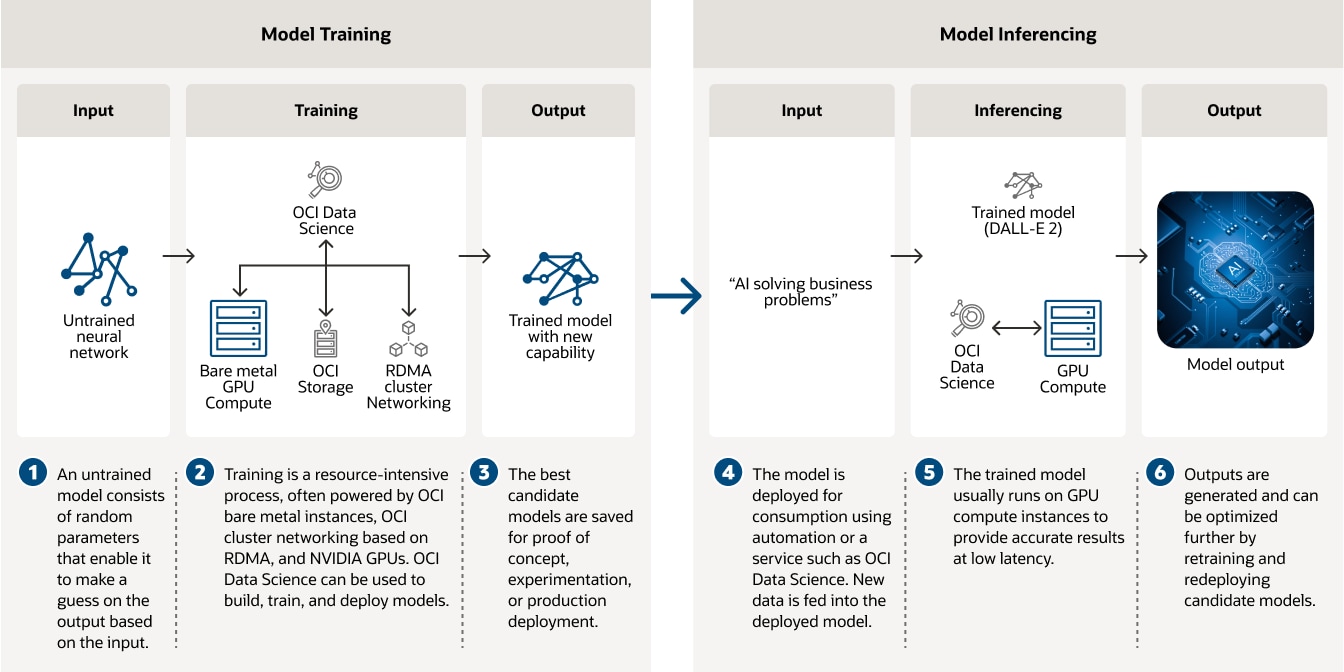

Infrastructure d'IA pour l'entraînement et l'inférence d'apprentissage profond

Entraînez des modèles d'IA à l'aide d'OCI Data Science, d'instances sans système d'exploitation, de réseaux de clusters utilisant le RDMA et des processeurs graphiques NVIDIA.

Ce diagramme décrit deux étapes du développement d'un modèle d'apprentissage profond : l'entraînement du modèle et l'inférence à partir du modèle. Dans l'entraînement du modèle (à gauche), le réseau neuronal non entraîné est soumis à un algorithme d'entraînement utilisant OCI Data Science, le calcul sans système d'exploitation, un stockage local et un réseau en cluster. L'algorithme d'entraînement produit un modèle entraîné avec une nouvelle fonctionnalité. L'étape d'inférence de modèle est décrite à droite. Par exemple, un modèle entraîné, tel que DALL-E 2, peut prendre des entrées de texte et générer des images. Une entrée de texte est introduite dans le modèle entraîné et le modèle génère une image.

Ce diagramme décrit deux étapes du développement d'un modèle d'apprentissage profond : l'entraînement du modèle et l'inférence à partir du modèle. Dans l'entraînement du modèle (à gauche), le réseau neuronal non entraîné est soumis à un algorithme d'entraînement utilisant OCI Data Science, le calcul sans système d'exploitation, un stockage local et un réseau en cluster. L'algorithme d'entraînement produit un modèle entraîné avec une nouvelle fonctionnalité. L'étape d'inférence de modèle est décrite à droite. Par exemple, un modèle entraîné, tel que DALL-E 2, peut prendre des entrées de texte et générer des images. Une entrée de texte est introduite dans le modèle entraîné et le modèle génère une image.

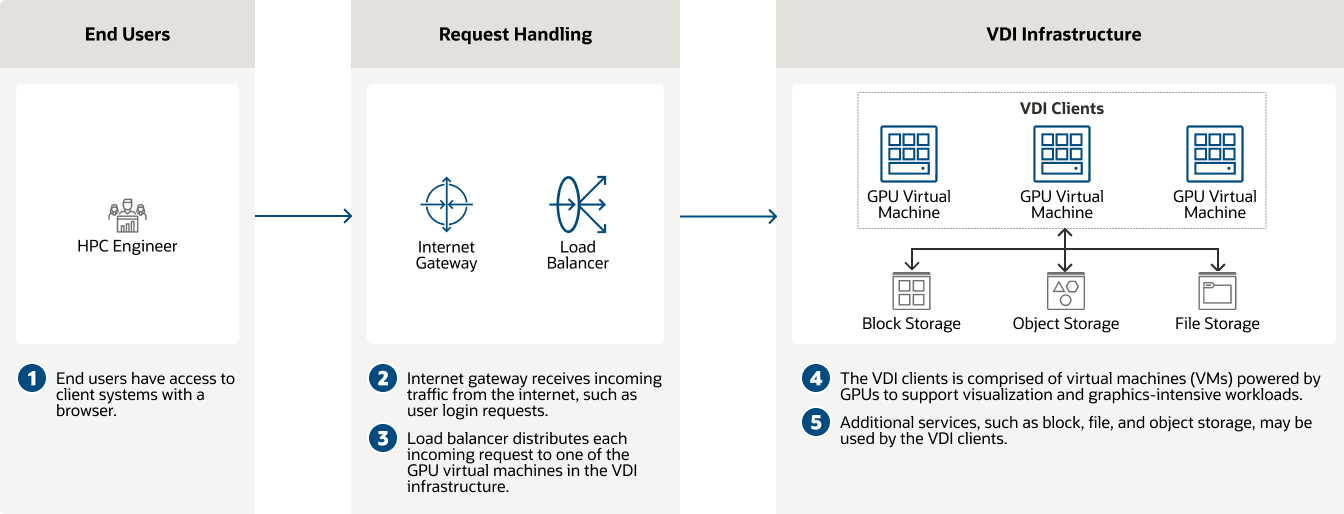

Infrastructure de bureau virtuel (VDI)

Les instances d'OCI Compute équipées de processeurs graphiques NVIDIA fournissent des performances élevées et constantes pour les VDI.

Infrastructure de bureau virtuel

Infrastructure de bureau virtuel

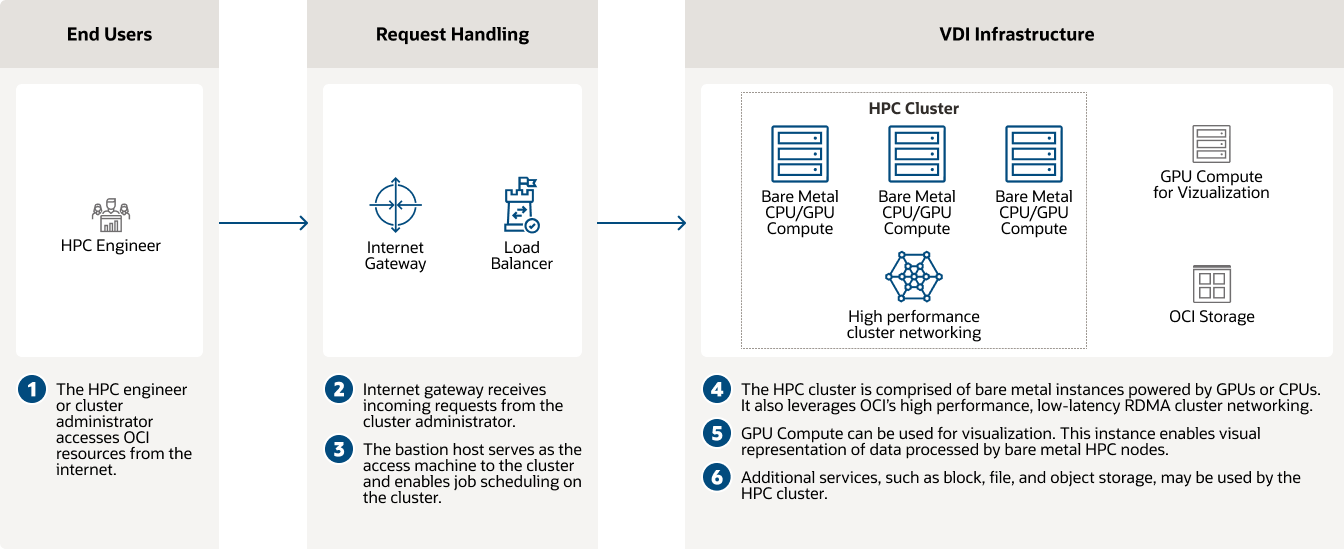

Mécanique des fluides numérique et calcul haute performance à l'aide d'instances GPU

OCI facilite l'ingénierie assistée par ordinateur et la dynamique des fluides numérique avec à la clé des prédictions rapides des propriétés aérodynamiques des objets.

Mécanique des fluides numérique et calcul haute performance à l'aide d'instances GPU

Mécanique des fluides numérique et calcul haute performance à l'aide d'instances GPU

Instances GPU—clients

Lancez-vous avec les instances GPU

Essayez Oracle AI gratuitement pendant 30 jours

Oracle offre un niveau gratuit pour la plupart des services d'IA ainsi qu'un compte d'essai gratuit avec 300 $ US de crédits pour tester ses services en nuage complémentaires. Les services d'IA comprennent un ensemble d'offres, incluant l'IA générative, avec des modèles d'apprentissage automatique prédéfinis qui permettent aux développeurs d'appliquer plus facilement l'IA aux applications et aux opérations métier.

-

Quels services d'IA ou d'apprentissage automatique d'Oracle offrent un niveau gratuit ?

- OCI Speech

- Langue OCI

- OCI Vision

- OCI Document Understanding

- Apprentissage automatique dans Oracle Database

- Étiquette de données OCI

Vous n'avez à payer que des frais de calcul et de stockage pour OCI Data Science.

Tirez parti des processeurs graphiques dès aujourd'hui

Découvrez comment Oracle aide les clients à tirer parti des processeurs graphiques NVIDIA et AMD pour une variété de cas d'utilisation de l'IA.

-

Que pouvez-vous faire avec les instances de processeur graphique ?

- Héberger des LLM avec les processeurs graphiques NVIDIA et AMD

- Exécuter un entraînement multinœuds distribué avec des processeurs graphiques NVIDIA

- Automatiser les tâches avec les LLM et la génération augmentée par extraction

- Mettre à l'échelle l'inférence NVIDIA NIM

Ressources supplémentaires

En savoir plus sur l'infrastructure pour l'IA, les services d'IA, l'IA générative et le calcul.

-

Documentation

-

Pages connexes

Découvrez combien vous pouvez réaliser des économies avec OCI

La tarification d'Oracle Cloud est simple, avec des tarifs faibles homogènes dans le monde entier et prenant en charge un large éventail de cas spécifiques. Pour estimer votre taux réduit, consultez l’estimateur de coûts et configurez les services en fonction de vos besoins.

Faites l’expérience de la différence

- 1/4 des coûts de bande passante sortante

- Rapport prix/performances de calcul 3 fois plus élevé

- Tarifs faibles et identiques dans chaque région

- Tarifs bas sans engagements à long terme

Entrez en contact avec des experts en processeurs graphiques et en IA

Obtenez de l'aide pour créer votre prochaine solution de GPU ou déployer votre charge de travail d'IA sur l'infrastructure OCI AI.

-

Ils peuvent répondre à des questions telles que :

- Comment se lancer avec Oracle Cloud ?

- Quels types de charges de travail d'IA puis-je exécuter sur OCI ?

- Quels types de services d'IA OCI propose-t-il ?